ページ読込中...

ページ読込中...

[English]

| 森島 繁生 [教授] |  |

|

| homepage | https://morishima-lab.jp/ | |

| 専門分野 | Computer Vision 音声・音響情報処理 Computer Graphics Human Computer Interaction Accessibility Artificial Intelligence |

|

| 研究テーマ・研究活動 | ||

| 1987 年 東京大学大学院工学系研究科博士課程修了 工学博士(東京大学) 1988 年 成蹊大学工学部電気工学科・助教授 1994 年-1995 年 トロント大学・客員教授 2001 年 成蹊大学工学部電気電子工学科・教授 2004 年 早稲田大学理工学部・教授 2020 年 CG Japan Award受賞 2021 年 IBM Academic Award受賞 情報処理学会フェロー, 画像電子学会フェロー, 日本顔学会理事 |

||

物理学を応用して人々に幸福をもたらすこと、安全・安心な社会、豊かな生活、日本の伝統文化などあらゆる面で、先端技術を通して貢献するというのが、森島研の研究目標です。あくまで最終のターゲットは人間の幸福や豊かな感性・文化に向けられているというのが特徴であり、研究者の自己満足に終わらせないことが重要なスタンスです。具体的には、物理、数学を道具だてとして使いこなし、ディジタル信号処理(SP)、コンピュータビジョン(CV)、コンピュータグラフィックス(CG)、ヒューマンコンピュータインタラクション(CHI)などの最先端の研究テーマを通して、世界に技術力をアピールするだけではなく、実際に目に見えるコンテンツや具体的に役に立つシステムとして具現化し、産業界に貢献していきます。

現在、下記の5つのグループで、研究を進めています。

1)人物Modelingチーム:人物3次元モデリング 表情アニメーション バーチャルヒューマン

2)Computer Vision・AIチーム:深層学習基礎 生成AI 言語処理 DeepFake対策

3)Rendering・Simulationチーム:流体・クロスシミュレーション フォトリアル高速レンダリング

4)音楽・音響チーム:音源分離 楽器音分離 マルチモーダル認識 リップシンク 読唇

5)Human Computer Interactionチーム:視覚障碍者支援 LLM応用 英文読解支援

実用的に成功した開発技術例として、2005 年の愛・地球博で実装され、164 万人に感動を与えた“Future Cast System” があります。これは長崎のハウステンボスで常設展示化されました。現在は深層学習の時

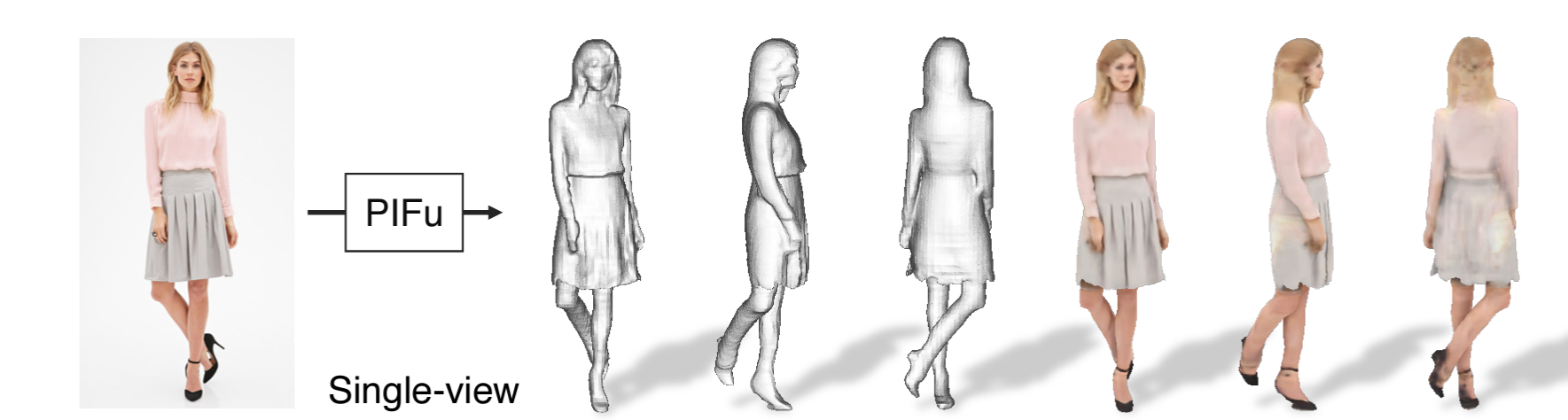

https://github.com/shunsukesaito/PIFu

https://github.com/shunsukesaito/PIFu

| Shigeo Morishima [Professor] |  |

|

| homepage | https://morishima-lab.jp/ | |

| research field | Physics-based Human Modeling and Image/Signal Processing Human Computer Interaction |

|

| research keywords | Computer Vision Speech/Music Signal Processing Computer Graphics Human Computer Interaction Accessibility Artificial Intelligence |

|

| link | https://researchmap.jp/futurecast | |

The research goal of the Morishima Laboratory is to contribute through advanced technology to all aspects of society, including the application of physics to bring happiness to people, a safe and secure society, a rich lifestyle, and traditional Japanese culture. Our research is characterized by the fact that our ultimate target is human happiness and enrichment of sensibilities and culture, and it is important not to end up with the self-satisfaction of researchers. Specifically, we use physics and mathematics as tools, and through cutting-edge research themes such as digital signal processing (SP), computer vision (CV), computer graphics (CG), and human-computer interaction (CHI), we not only appeal to the world with our technological capabilities, but also contribute to industry by embodying them in the form of tangible content and concretely useful systems.

One of the most successful research applications is “Future Cast System” which was presented at Expo 2005 in Mitsu-Toshiba pavilion where total 1,640,000 people enjoyed the state-of-the-art technology as a digital virtual movie actor. This system moved to Huis Ten Bosch in Nakagasiki as a permanent attraction for 12 years. Now Deep Learning era is coming, we have shifted research topic to AI-based system. One of the most impact research paper was “PIFu” at ICCV 2019 which is one of the top conferences in the Computer Vision field and it has been recognized as the pioneer research in “Neural Field”. It recorded over 1000 in the reference number only in 4 years after presentation.